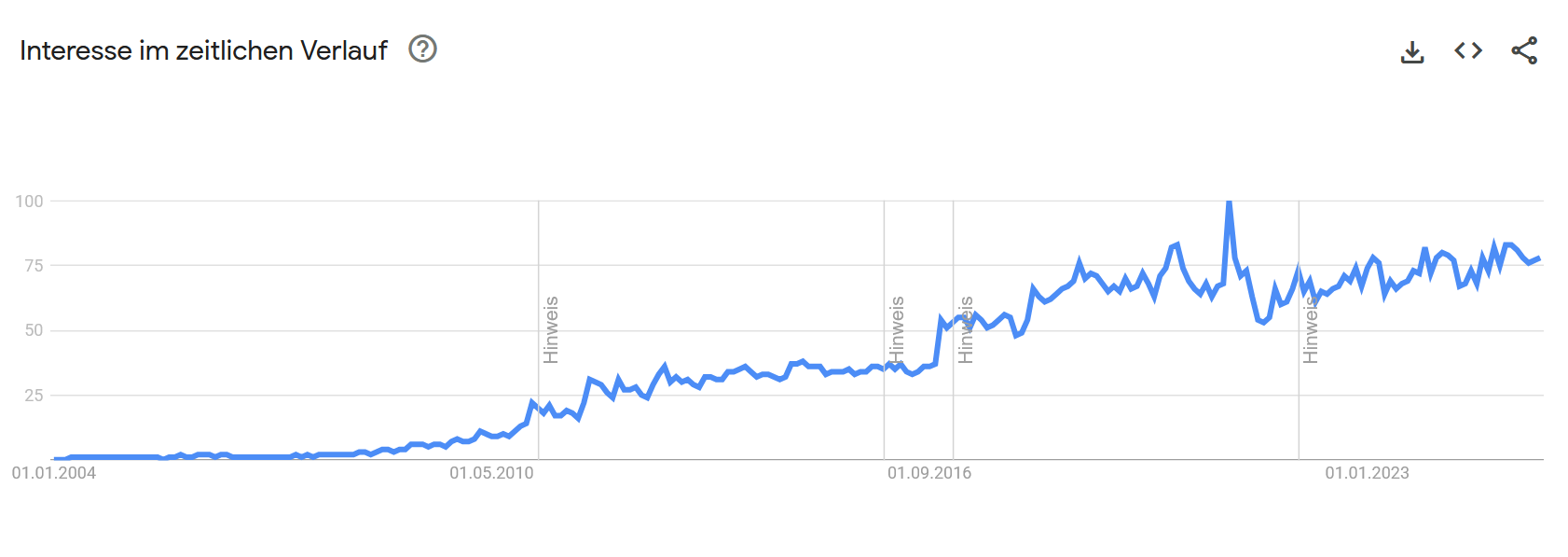

Das Themenfeld „Cloud Computing“ erreichte laut Google Trends sein größtes Suchvolumen im Dezember 2020 und hält seither ein konstant hohes Interesse. Angesichts aktueller Herausforderungen – vom wachsenden Einfluss großer KI‑Modelle bis zu immer extremeren Spitzen und Tälern im weltweiten Warenfluss – lohnt sich der Blick durch die Intralogistik‑Brille.

Was ist die Cloud?

Das vielzitierte „The cloud is just someone else’s computer“ greift zu kurz. Eine präzisere Beschreibung aus unserer Sicht wäre: „The cloud is someone else’s computer which is better automated and standardized than your data processing center.“ Physisch besteht sie aus Massen günstiger, hochvernetzter Hardware in Clustern. Redundanz entsteht dort hauptsächlich auf Softwareebene, weil nahezu jeder Prozess von Provisionierung über Monitoring bis zum Failover automatisiert ist. Was dazu führen kann, dass defekte Komponenten oft monatelang unbemerkt bleiben, da Workloads automatisch migriert werden. Was einen besseren Eindruck in die Leistungsfähigkeit der Cloud vermittelt, als mit technischen Daten um sich zu werfen.

Warum spielt Automatisierung hier eine Schlüsselrolle?

Standardisierte Schnittstellen (z. B. über Kubernetes‑APIs) ermöglichen es, Infrastruktur per Code zu steuern. Dadurch wird Skalierung plan‑ und prüfbar, während sich Betriebsteams auf Prozess‑ und Qualitätsverbesserungen statt manueller Arbeit an der Infrastruktur konzentrieren können.

Was sind die Anforderungen?

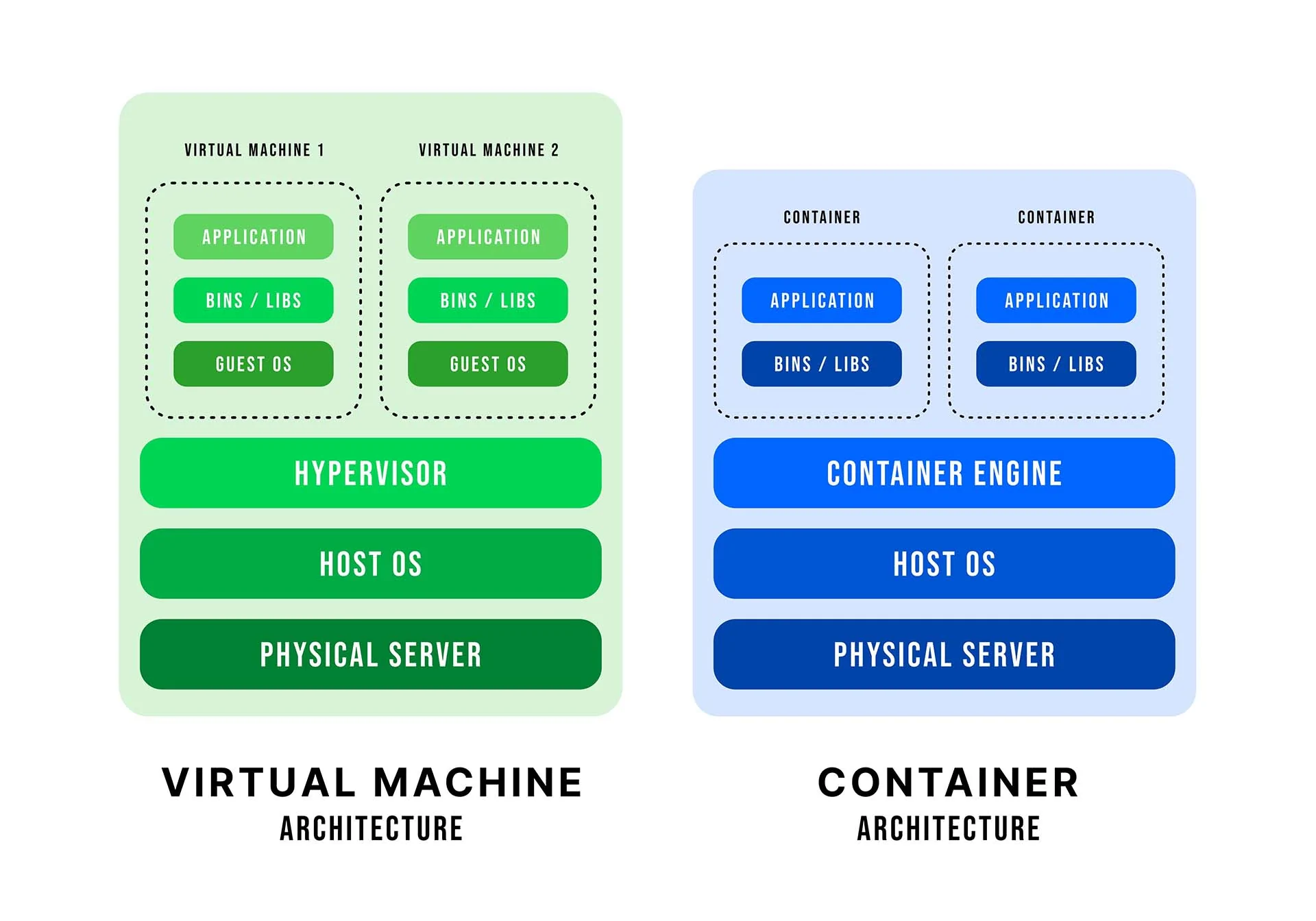

Eine reine 1‑zu‑1‑Migration bestehender Server ein Cluster eines Hyperscalers oder in die eigene Cloud schöpft deren Potential kaum aus. Zwar lassen sich dort virtuelle Maschinen wie gewohnt hochfahren, doch skalieren sie als monolithische Blöcke.

Ein Beispiel

Ein Unternehmen repliziert seine Intralogistik‑Applikation, wie ein WMS, dreimal, um Redundanz zu erhalten. Jede Instanz beinhaltet sämtliche Abhängigkeiten – der Ressourcenbedarf vervielfacht sich entsprechend. Nach aktuellen Standards trennt man stattdessen funktionsspezifische Komponenten in Container und orchestriert sie über cloud‑native Lösungen. Dadurch skaliert, patcht oder ersetzt man nur jene Softwarekomponenten, die tatsächlich Lastspitzen erzeugen.

Die Grundlagen

Für einen ressourceneffizienten Cloud‑Einsatz in der Intralogistik sollten daher folgende Grundlagen erfüllt sein:

- Container‑ und hexagonale Architektur – Modularer Aufbau und lose Kopplung vereinfachen Skalierung, Tests und Wartung.

- DevOps‑Prinzipien – Eine enge Verzahnung von Entwicklung & Betrieb verkürzt Release‑Zyklen und sichert Qualität.

- Kenntnis marktführender Standards – Kubernetes, AWS‑ oder Google‑Cloud‑Services u. a. bilden das Fundament für Portabilität und Automatisierung.

Die Vorteile

Stimmen die Grundlagen, wird Rechenleistung zu einer skalierbaren Ressource, die nur Kosten verursacht, wenn sie tatsächlich gebraucht wird. Infrastruktur lässt sich per Knopfdruck bereitstellen, erweitern oder abschalten. Prozesse – etwa Test‐Deployments neuer Softwarestände – binden damit keine dauerhaften On‑Premises‑Kapazitäten mehr, sondern werden situationsabhängig in der Cloud betrieben. Das beschleunigt Projekte und senkt Fixkosten.

Weitere zentrale Vorteile

- Schnelle Implementierung & Test neuer Prozesse – Isolierte Testumgebungen lassen sich binnen Minuten aufsetzen und nach Abschluss rückstandsfrei entfernen.

- Kosteneffizienz – Pay‑as‑you‑go‑Modelle vermeiden Über‑Provisionierung; wer lokal bereits ausreichend Leistung hat, kann Lastspitzen trotzdem günstiger in die Cloud verlagern.

- Standardisierung & Anbieterunabhängigkeit – Offene Schnittstellen reduzieren Lock‑in‑Risiken und erleichtern den Wechsel zwischen Providern, falls keine eigenen Cluster zur Verfügung stehen.

„Never touch a running system“ – aber nicht um jeden Preis

Früher oder später erfordert der Betrieb neue Fördertechnik, zusätzliche MDE‑Geräte oder Sicherheits‑Updates. Ein prominentes – weil langlebiges – Beispiel ist Windows CE, dessen finaler Release 2023 war. Je älter die Plattform, desto höher die Risiken (Sicherheitslücken, fehlende Ersatzteile). Dort waren die Nutzeroberflächen noch eng mit den Geräten in Form spezialisierter Software verbunden. Die Cloud erleichtert hier den Sprung auf moderne Architekturen und eine situationsabhängige Skalierung: Web‑basierte Oberflächen lassen sich zentral bereitstellen und versorgen via elastischer Cluster an Einkaufs‑Aktionstagen hunderte Geräte – während im Sommerloch nur ein Bruchteil der Ressourcen läuft und damit auch entsprechend Budget spart.

Warum ein Exkurs zur GUI?

Web‑Frontends illustrieren den unmittelbaren Nutzen von Cloud‑Skalierung: Statt für jedes Endgerät eigene Apps und Update‑Routinen zu pflegen, liefert ein Cluster einheitliche Oberflächen aus. Dieser Mehrwert ist nicht ausschließlich, aber besonders leicht in Cloud‑Umgebungen umzusetzen, weil dort Skalierung besonders einfach ist.

Gleichwohl gilt: Hohe Latenzanforderungen im Millisekunden‑Bereich (z. B. Materialflusssteuerung) oder strikte Sicherheitsvorgaben können Edge‑ oder On‑Premises‑Ansätze erforderlich machen. Die Entscheidung bleibt daher stets kontextabhängig.

Rechenleistung als Versorgungsmedium

So wie Strom oder Wasser selbstverständlich aus der Leitung kommt, wird Rechenleistung in einer gut automatisierten Umgebung unsichtbar: Lastverteilung, Monitoring und Self‑Healing laufen im Hintergrund, während das Fachteam lediglich steuert, ob mehr oder weniger Ressourcen benötigt werden. So denken und leben wir Software.

Grenzen der Cloud

Die Cloud ist keine eierlegende Wollmilchsau. Für ultra‑niedrige Latenzen oder wenn Daten physisch in einer gesicherten Umgebung verbleiben müssen, ist ein hybrides Modell oder eine On‑Premises‑Lösung sinnvoll. Für Prozesse, die „nur“ Reaktionszeiten im Zehntelsekunden erfordern, überwiegen jedoch häufig die Vorteile der Cloud.

Fazit

Für Entscheider wird der Weg in die Cloud zunehmend attraktiver: Skalierbarkeit, Flexibilität und schnellere Innovationszyklen bieten handfeste Vorteile. Wer jedoch lediglich alte Monolithen verschiebt, schöpft das Potenzial nur teilweise aus. Erst cloud‑native Architekturen, die Funktions‑ und Infrastruktur‑Automatisierung kombinieren, maximieren den ROI – gerade in einer Intralogistik, deren Lastprofile von Black‑Friday‑Peaks bis zum Sommerloch reichen.

Unsere weiteren Blogbeiträge

Zurück zur Startseite

Wie wir Datenerfassung mit mobilen Endgeräten lösen